Es bien sabido que las nuevas tecnologías en la Inteligencia Artificial, particularmente las que se refieren a redes neuronales, han tenido mucho éxito en resolver una serie de problemas, incluso en temas como el juego del Go, el cual se supone es mucho más complejo que el ajedrez y en donde AlphaGo, de DeepMind, se ha convertido en un programa imbatible.

Sin embargo, lo que parece que aún no pueden hacer es explicar cómo llegaron a las conclusiones, a los resultados, los cuales casi siempre sobrepasan al de los expertos humanos. Y es aquí donde se trabaja intensamente, en poder tener sistemas que expliquen cómo es que estas poderosas redes neuronales, llegan a las conclusiones que llegan.

En busca de una explicación

Decodea.ai es una empresa de software, de inteligencia artificial, que declara tener un sistema llamado XAI – Explainable Artificial Intelligence, que puede explicar las razones por las que los programas inteligentes llegan a sus respectivas conclusiones. Su esquema parte de 4 bases:

- Modelar el pensamiento humano, es decir, modelar cómo los humanos explican sus recomendaciones.

- Identificar conceptos de alto nivel, es decir, tener cadenas de deducción y relaciones causales en situaciones concretas.

- Operar en sistemas dinámicos, o lo que es lo mismo, decir que las explicaciones son específicas a situaciones y no estáticas.

- Compensación de rendimiento cero, que no es otra cosa que decir que las explicaciones son independientes a los sistemas de IA a la mano.

La credibilidad de los resultados

La idea de Decodea.ai suena interesante, pero ¿cómo validar sus resultados? La compañía tomó la decisión de probar su sistema con el ajedrez, debido a que es un tema de inteligencia artificial que permite investigar y modelar el razonamiento humano en situaciones complejas.

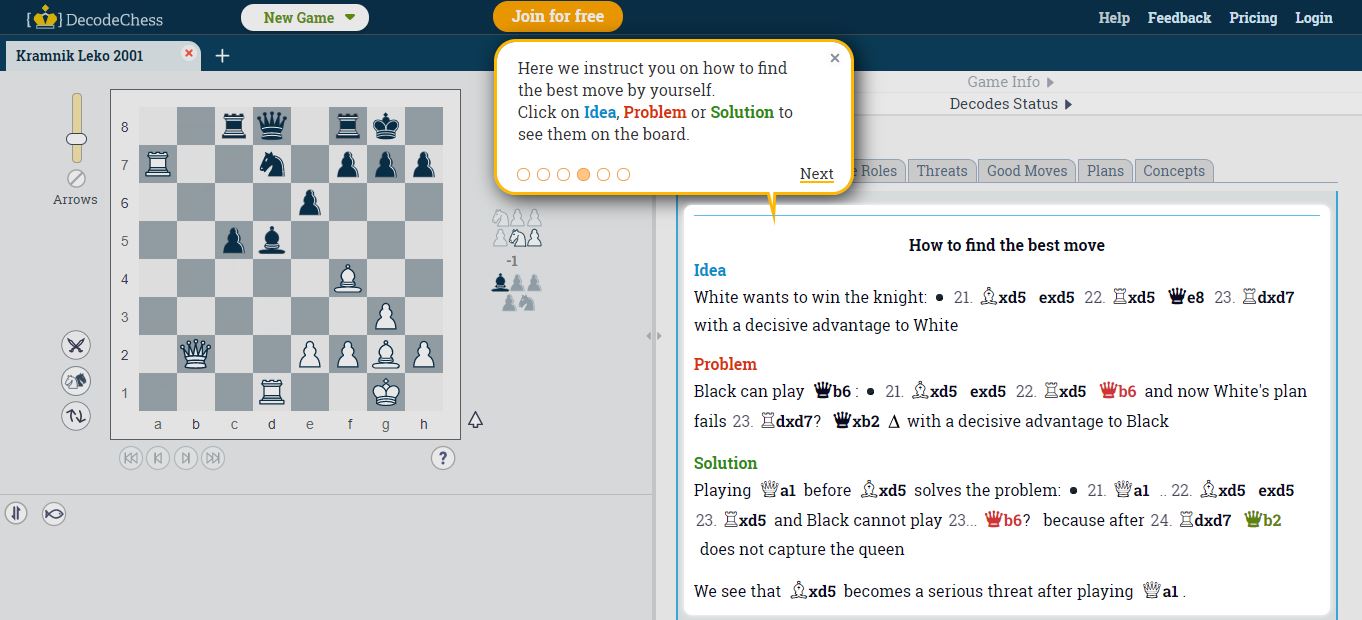

El «debut» de la empresa se llama DecodeChess, que es el primer tutor de ajedrez que combina el mérito de un programa de ajedrez y el de un maestro de la especialidad humano.

De hecho, ponen varios ejemplos de su sistema analizando posiciones de ajedrez y explicándolas a nivel humano (y no sólo por centésimas de peón, que es la medida de la ventaja para las apps de ajedrez). Así, el sistema no sólo nos da un resumen de lo que ha encontrado, sino del rol de cada pieza, las amenazas de las mismas, las que considera buenas jugadas, los planes y los conceptos atrás de esto.

Da la impresión de que estamos ante un tutor de ajedrez inteligente, y habría que preguntarse si el sistema de Decodea.ai puede trasladarse a otros dominios del conocimiento. Y esta es la gran pregunta, porque por muchos años, algunos esquemas muy interesantes del pasado nunca pudieron extenderse a otros dominios, como en el caso de Shruldu.