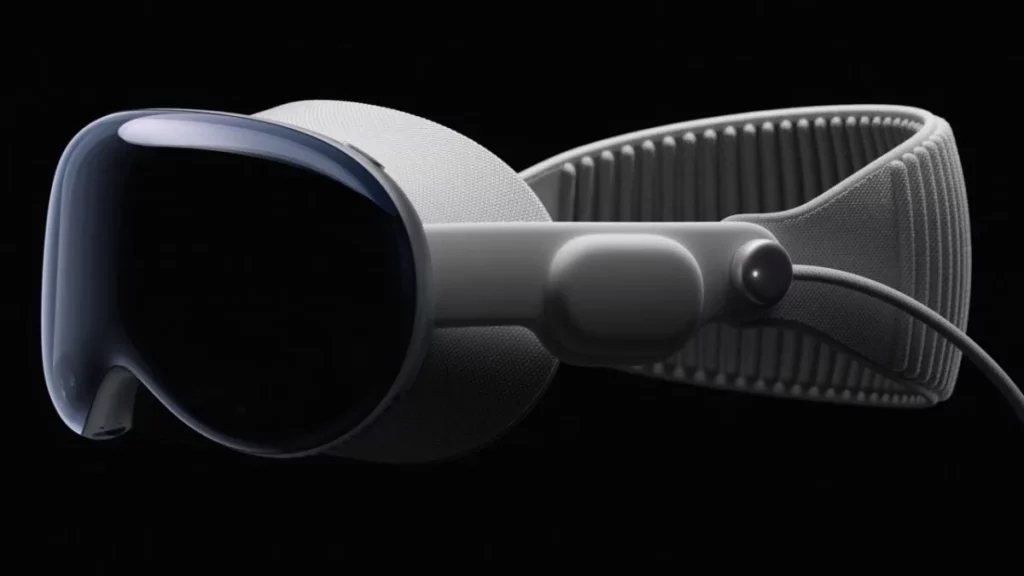

A principios de junio, Apple presentó oficialmente las esperadas gafas de realidad virtual, conocidas como Apple Vision Pro, las cuales también son compatibles con la realidad aumentada.

Aunque el dispositivo ofrece una variedad de características, una funcionalidad que no fue mencionada por Tim Cook ni por el equipo de Apple es la supuesta capacidad del gadget para leer la mente.

Apple Vision Pro: ¿lee la mente a través de la IA?

Recientes declaraciones de un ex investigador de prototipos de neurotecnología en Apple han generado preocupación y especulación acerca de las capacidades del visor Apple Vision Pro.

Sterling Crispin, quien afirma haber participado en el desarrollo de Vision Pro mientras trabajaba en Apple, ha utilizado Twitter para insinuar que el dispositivo o sus futuras versiones podrían contar con capacidades de lectura mental, lo cual ha captado la atención del público.

Crispin afirma que una gran parte de la tecnología que desarrolló mientras estuvo en Apple es de carácter confidencial. No obstante, mencionó que debido a la divulgación de algunos aspectos de su trabajo a través de patentes, ahora tiene permiso para hablar sobre ellos.

Apple usa datos biométricos para detectar el estado mental de los usuarios

Crispin explicó en un tuit que en términos generales, gran parte de su trabajo consistió en detectar el estado mental de los usuarios utilizando datos de su cuerpo y cerebro durante experiencias inmersivas.

Estos estados podrían ser evaluados mediante parámetros como los movimientos oculares, la actividad cerebral, los latidos del corazón, la actividad muscular y la presión arterial. Además, también se podrían considerar la densidad sanguínea cerebral, la conductancia de la piel y otros indicadores.

Con base en estos datos, los modelos de IA buscan predecir estados cognitivos como curiosidad, distracción, miedo, concentración, recuerdo de experiencias pasadas y otros.

El análisis de IA en aplicaciones de realidad mixta o realidad virtual busca detectar tanto estados emocionales como intenciones cognitivas de los usuarios.

En sus tuits, el investigador reveló su participación en tecnologías de predicción de decisiones del usuario, similar a una lectura mental realizada por la IA.

Crispin explicó que la reacción de la pupila antes de hacer clic se debe en parte a la expectativa de un resultado posterior.

Monitoreando el comportamiento ocular, se genera retroalimentación con el cerebro y se rediseña la interfaz de usuario en tiempo real para anticipar la pupila.

Describió esto como una interfaz cerebro-computadora rudimentaria que se basa en los ojos.

Apple Vision Pro ¿sabe qué tan concentrado estás?

Crispin también estuvo involucrado en el desarrollo de tecnologías para predecir el estado de concentración o relajación de los usuarios.

El análisis de señales corporales y cerebrales permite determinar el nivel de concentración, relajación e intensidad de estudio, según Crispin.

Estos conocimientos podrían haber sido aplicados en los entornos de oficina o de meditación inmersivos de Apple.

Según Crispin, los entornos virtuales podrían actualizarse en tiempo real utilizando estos datos para mejorar la concentración. «Imagínate un entorno inmersivo adaptable que te ayude a aprender, trabajar o relajarte cambiando lo que ves y escuchas en segundo plano».

Hasta ahora, Apple solo ha introducido un control en el marco de los auriculares que permite a los usuarios ajustar personalmente el nivel de inmersión.

Crispin no está seguro de qué tecnologías descritas fueron realmente incorporadas al Apple Vision Pro y en qué medida: «Estoy muy interesado en saber qué se implementó y qué se lanzará en el futuro». Crispin abandonó la empresa a finales de 2021.

¿Invasión de la privacidad?

La revelación generó inquietudes sobre la privacidad y la posible intrusión en los pensamientos y sentimientos de las personas, como se esperaba.

El dispositivo que revela emociones plantea interrogantes éticas sobre los límites del acceso a información personal por parte de las empresas.

Crispin mencionó que la IA puede influir en la experiencia del usuario con imágenes y sonidos sutiles, evaluando sus respuestas.

Este aspecto ha avivado aún más las preocupaciones sobre la manipulación y las implicaciones éticas de utilizar esta tecnología sin el consentimiento explícito del usuario.

Aunque las declaraciones de Crispin revelan posibles capacidades de lectura mental, es importante destacar que Apple no ha confirmado ni anunciado oficialmente estas funciones. Es necesario tener cautela y esperar a que la empresa se pronuncie al respecto.

Durante la presentación inaugural de la WWDC23, Apple se enfocó en las características de seguimiento ocular y computación espacial de Vision Pro. Sin embargo, no mencionaron explícitamente los sensores adicionales o las capacidades de lectura mental descritas en el hilo de Crispin.